LLMを利用する

LLMをデプロイする

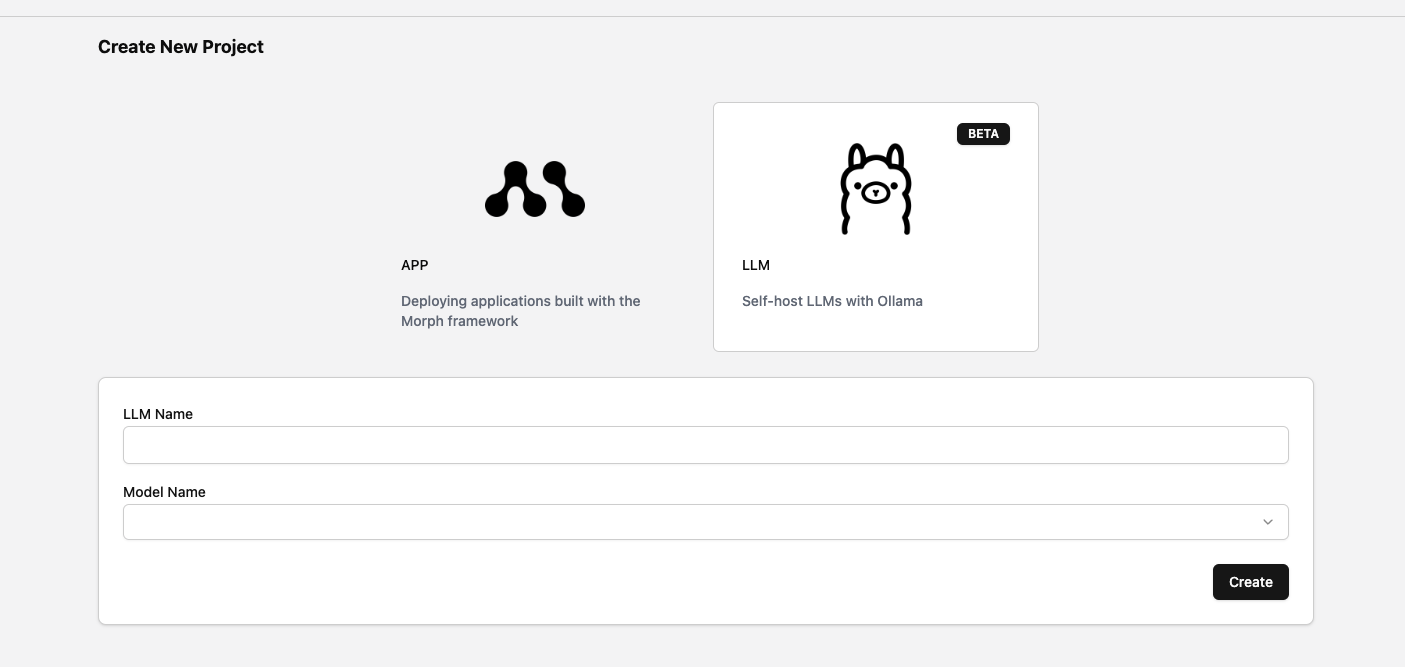

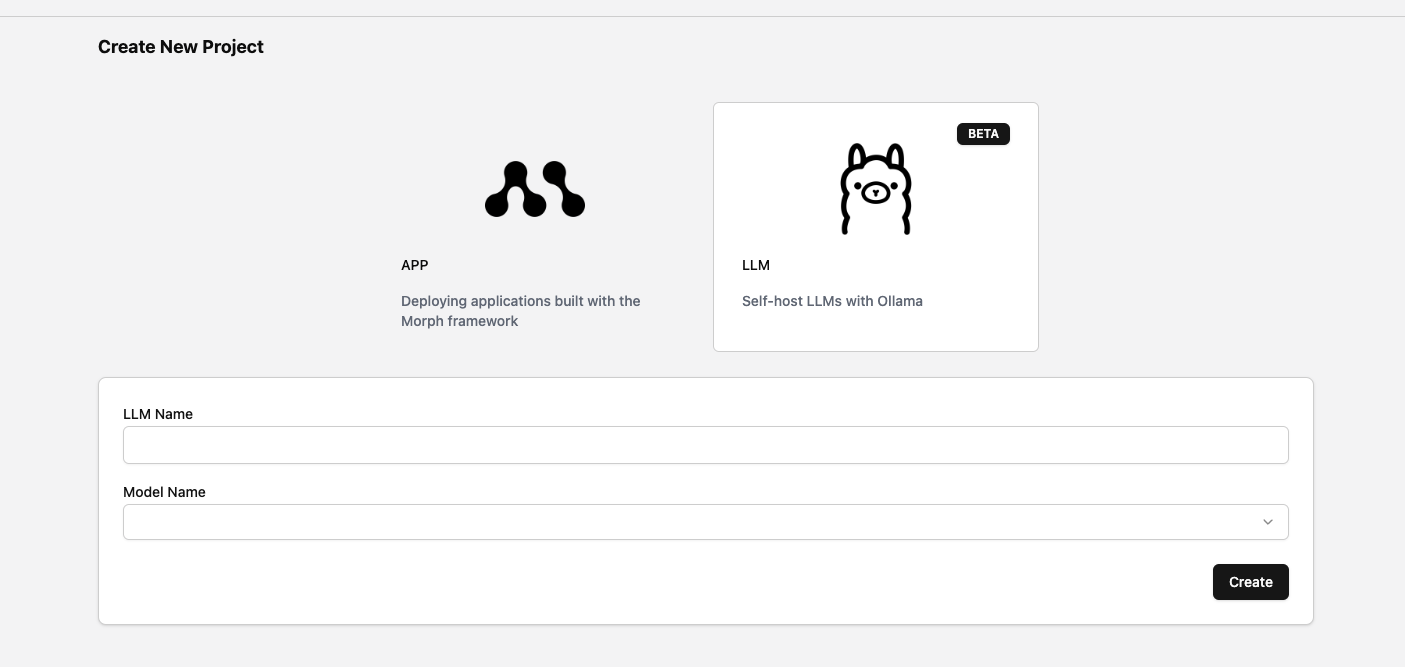

ダッシュボードのLLMタブを押下しLLM作成画面に遷移します。任意の

LLM Nameを入力し、使用するModel Nameを選択します。

| Model | Parameters |

|---|---|

deepseek-r1 | 1.5b, 7b, 8b, 14b |

llama3.2 | 8b |

phi4 | 14b |

qwen | 0.5b, 1.8b, 4b, 7b, 14b |

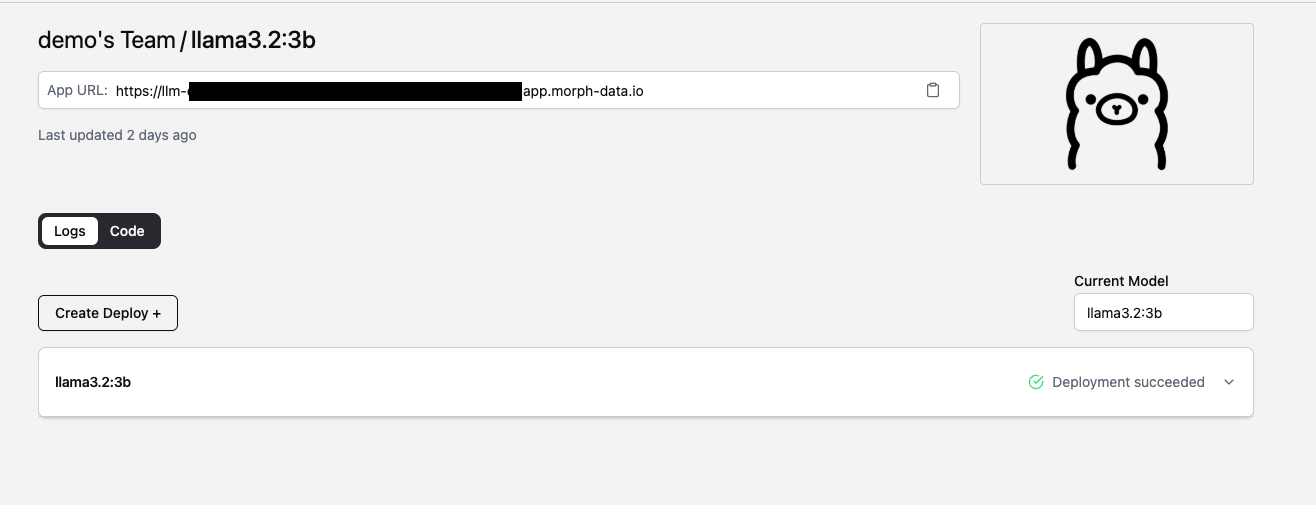

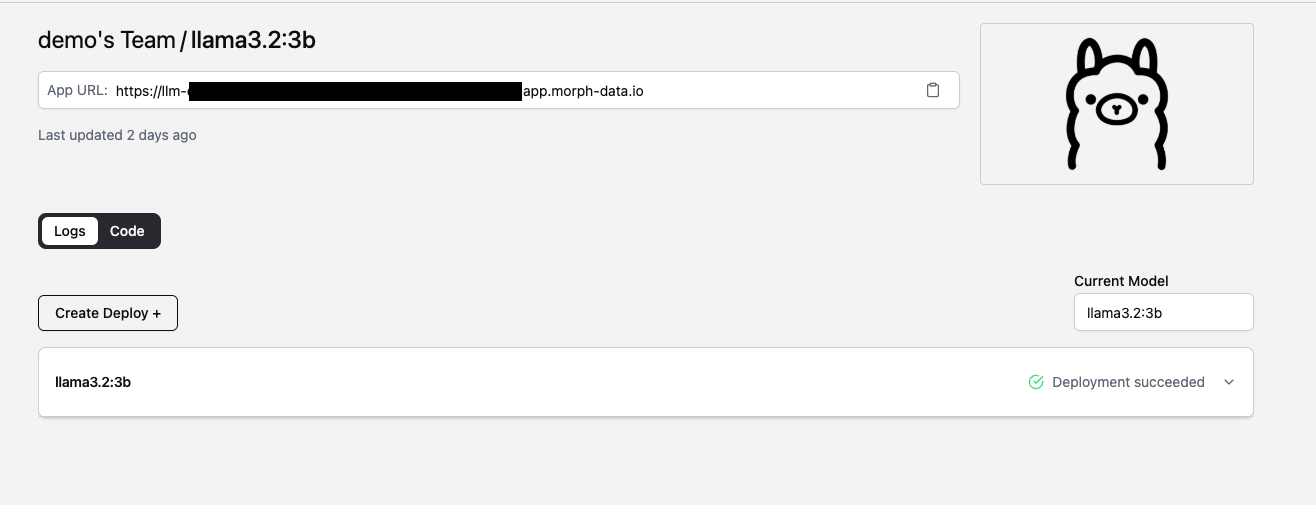

作成したモデルを確認する

LLMタブから作成したLLMを選択します。

Deployment Succeededであれば作成が成功しています。まだ進行中の場合は作成完了までお待ちください。App URLはMorphにホストされたLLMのURLです。このURLとMorphのAPI Keyを使用してLLMにリクエストを送ることが可能です。